OpenAI ha ridotto gli errori, ma le informazioni fuorvianti rimangono un rischio concreto: il 37% delle risposte di GPT 4.5 è falso

📌 TAKE AWAYS

- Nonostante i progressi rispetto ai modelli precedenti, GPT 4.5 continua a generare informazioni false in circa il 37% dei casi.

- L’affidamento cieco a modelli come ChatGPT per contenuti, assistenza clienti e ricerca di mercato può portare a conseguenze negative, tra cui diffusione di dati errati, perdita di fiducia da parte dei clienti e penalizzazioni SEO.

- La natura stessa degli LLM rende impossibile garantire un’accuratezza del 100%, il controllo umano è fondamentale per un uso consapevole di questi strumenti.

ChatGPT 4.5 continua a soffrire di allucinazioni, generando risposte false nel 37% dei casi, nonostante i miglioramenti rispetto ai modelli precedenti.

Questo problema rende l’IA inaffidabile per compiti critici, con rischi concreti per chi si affida ciecamente alle sue risposte.

Soluzioni come il "ragionamento automatico" potrebbero ridurre gli errori, ma l'eliminazione totale delle allucinazioni rimane un'utopia.

La Silicon Valley ci ha abituato a tutto. Lanci sensazionalistici, promesse di rivoluzioni imminenti, proclami che spesso si sciolgono come un ghiacciolo sul cruscotto ad agosto. E OpenAI, la startup che ha acceso i riflettori sull’intelligenza artificiale generativa con ChatGPT, non fa eccezione.

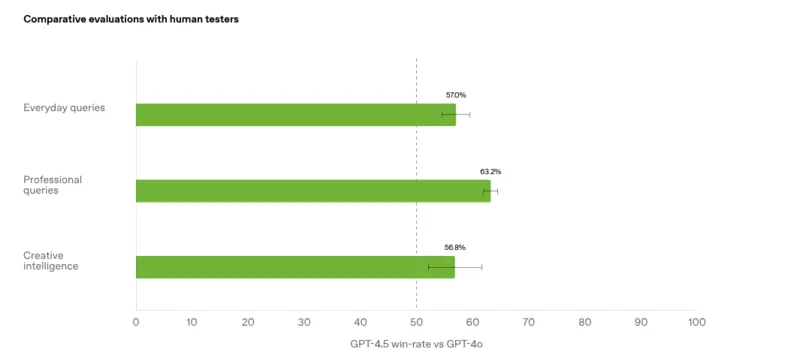

Ricordi l’annuncio, quasi sussurrato, del ritiro di o3? Quasi un passo indietro silenzioso, una mezza ammissione di difficoltà. E poi, come un prestigiatore che estrae il coniglio dal cilindro, ecco spuntare GPT 5, ribattezzato poi, con un’altra giravolta, GPT 4.5.

“Il modello più grande e migliore di sempre!”, esultano da San Francisco.

Peccato che il problema delle allucinazioni non sia stato affatto risolto. Non visioni psichedeliche di un nomade del deserto, ma veri e propri errori, invenzioni spacciate per verità, risposte sbagliate che escono con la stessa sicurezza di quelle corrette.

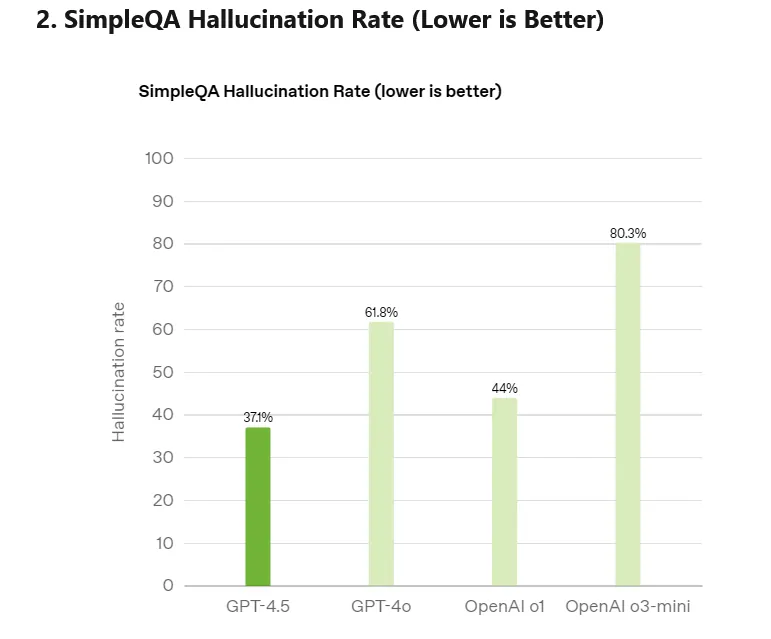

È OpenAI stessa ad ammetterlo: GPT 4.5, l’ultima versione, ha allucinazioni nel 37% dei casi. Quasi una risposta su tre di ChatGPT è, potenzialmente, una falsità.

Il vecchio modello ne aveva il 61,8% delle volte. Per cui, un netto miglioramento, certo. Ma non ancora abbastanza per fidarsi della creatura di Altman (come sanno bene gli utenti).

Sei stupito da questi dati? Di che partito fai parte? Sei tra quelli che si affidano completamente agli LLM e alle IA o diffidi dalle loro risposte e verifichi sempre le fonti?

Sai benissimo quanto la reputazione online sia vitale per chiunque lavori sul web: pubblicare falsità o notizie non verificate può compromettere la fiducia dei tuoi clienti. E allora, vale la pena utilizzare degli strumenti che “ti mentono” quasi una volta su tre? Qual è il modo corretto di relazionarsi con le IA (se ce n’è uno)? Il gioco vale davvero la candela? È quello che proveremo a capire in quest’articolo.

Le statistiche su ChatGPT sono impietose (secondo la stessa OpenAI)

Non ci credi? Non pensi che il problema sia così grave? Lasciamo parlare i dati, quelli forniti dalla stessa OpenAI.

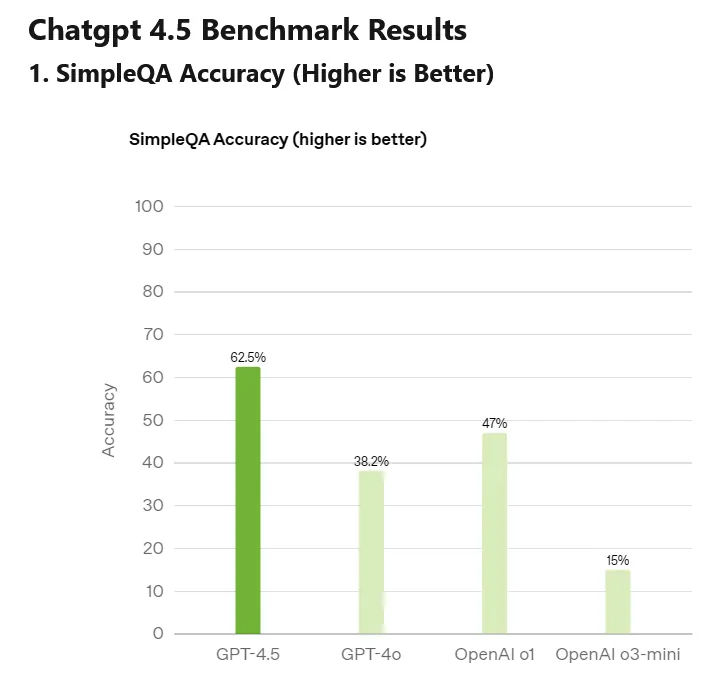

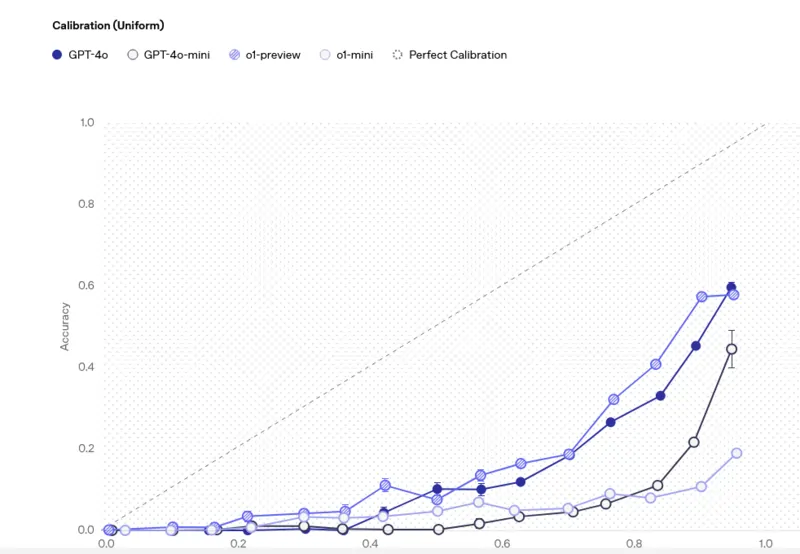

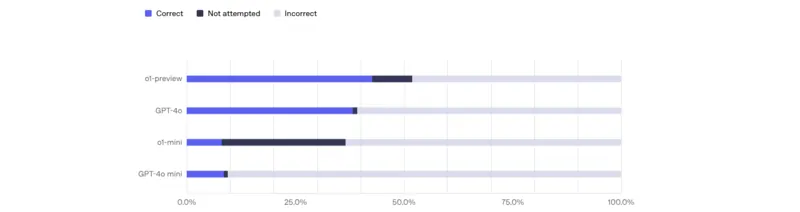

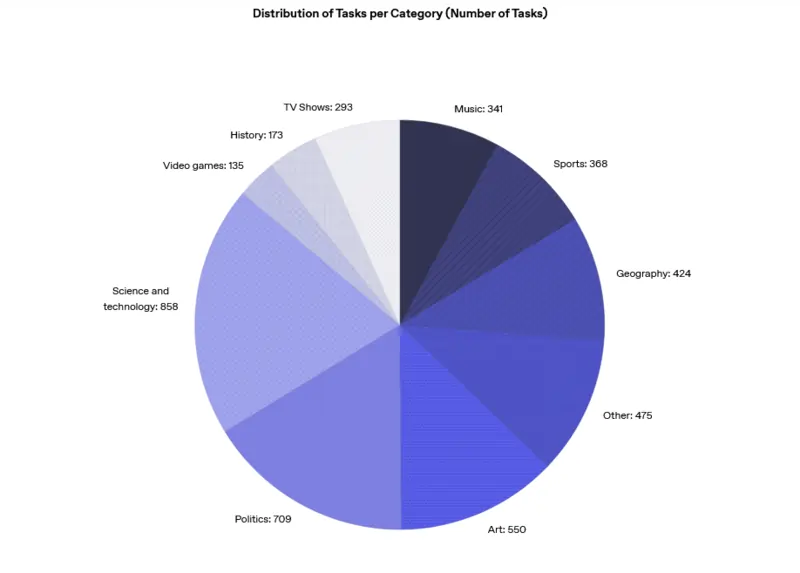

I primi test sui benchmark di factuality, utili per valutare la tendenza dei modelli a “inventare” informazioni, parlano chiaro. Nel test SimpleQA, progettato per mettere alla prova la conoscenza fattuale, GPT-4.5 ha raggiunto un’accuratezza del 62.5%, surclassando nettamente GPT-4o (fermo al 38.2%).

E sul fronte delle allucinazioni? Il nuovo modello le riduce drasticamente al 37.1%, rispetto al 61.8% del suo predecessore. Questi dati, pubblicati da OpenAI, evidenziano come GPT-4.5, grazie a tecniche avanzate di apprendimento non supervisionato, dimostri una comprensione del mondo più solida e una maggiore aderenza alla realtà. Ma dovremmo esultare per un tasso di allucinazione del 37,1%? Non ne sarei così convinto…

È come avere un dipendente che, per la maggior parte del tempo, ti racconta frottole con la massima convinzione. Ti fideresti ad affidargli compiti importanti per la tua azienda? Probabilmente no. Eppure, molti imprenditori si affidano ciecamente a ChatGPT per compiti delicati come la creazione di contenuti, la ricerca di informazioni di mercato, l’assistenza clienti. Un errore che può costare caro.

Wenting Zhao, ricercatrice di Cornell, che ha studiato a fondo il fenomeno delle allucinazioni AI, è chiara:

“Al momento, i modelli migliori riescono a generare testi privi di allucinazioni solo nel 35% dei casi“.

E la conclusione è netta: “Non possiamo ancora fidarci completamente dei risultati generati dai modelli”.

Capisci l’impatto di queste parole? Non stiamo parlando di piccoli errori veniali, di imprecisioni trascurabili. Stiamo parlando di un problema strutturale, di una falla profonda nell’affidabilità di una tecnologia che, se usata acriticamente, può creare parecchi problemi.

Il rischio di affidarsi completamente alle IA

“Ok, i numeri sono preoccupanti”, potresti pensare. “Ma in pratica, cosa significa per me, imprenditore online?”. Significa che affidarti ciecamente a ChatGPT per compiti importanti per il tuo business è un rischio enorme. Le allucinazioni non sono innocue “sviste” algoritmiche. Possono tradursi in errori concreti, con conseguenze reali per la tua attività.

Vuoi qualche esempio? Pensa di generare descrizioni di prodotti per il tuo e-commerce. Se il chatbot è in preda ad allucinazioni, potrebbe inventare caratteristiche inesistenti, promettere funzionalità che i tuoi prodotti non hanno, fuorviare i clienti e danneggiare la tua reputazione.

Oppure, pensa di utilizzare ChatGPT per rispondere alle domande dei clienti via chat. Un’allucinazione potrebbe portare a fornire informazioni errate su prezzi, spedizioni, resi, creando confusione e insoddisfazione tra i tuoi acquirenti.

E che dire della SEO? Se utilizzi ChatGPT per creare contenuti per il tuo blog o il tuo sito web, e il chatbot include informazioni false o imprecise, rischi di penalizzare il tuo posizionamento su Google, di perdere credibilità agli occhi degli utenti e di vanificare i tuoi sforzi di marketing.

Non sono scenari ipotetici ma rischi concreti.

Il giornalista tedesco Martin Bernklau ne sa qualcosa. Digitando il suo nome in Copilot, l’IA di Microsoft, si è ritrovato descritto come un criminale, un truffatore, uno spacciatore. Tutte invenzioni pure, allucinazioni che hanno danneggiato la sua reputazione e lo hanno spinto a intraprendere azioni legali.

Anche il sindaco australiano Brian Hood ha subito le conseguenze delle allucinazioni di ChatGPT, venendo falsamente accusato di essere un delinquente pregiudicato, come racconta il Washington Post. E il conduttore radiofonico americano Mark Walters è finito in tribunale per una diffamazione inventata da ChatGPT.

Questi casi sono la punta dell’iceberg di un problema molto più vasto. Le allucinazioni di ChatGPT possono danneggiare la reputazione, minare la fiducia dei clienti, compromettere la SEO e, in definitiva, intaccare il tuo fatturato.

Per questo motivo, utilizzare le IA senza il supporto di esperti SEO, specie se si tratta del tuo business, può essere davvero rischioso. Lo dimostrano numerosi studi…

Tre studi non confortanti sulle allucinazioni delle IA

Forse penserai che sto esagerando nel metterti in guardia su un uso irresponsabile delle IA. Ma un recente studio di Microsoft ha confermato i miei dubbi.

Pensa che ha rivelato che il 26% degli utenti di IA si affida ciecamente alle risposte, accettandole come vere senza applicare un pensiero critico, mentre solo una piccola minoranza (7%) si preoccupa di verificare l’autenticità delle fonti citate.

Questa fiducia incondizionata è particolarmente rischiosa anche alla luce delle scoperte di Robin Emsley.

Testando il chatbot, Emsley ha riscontrato che su cinque riferimenti bibliografici, tre erano completamente inventati e uno irrilevante, oltre a distorsioni di studi reali. Indagini successive hanno confermato la gravità del problema: uno studio su 178 citazioni di ChatGPT ha trovato che il 39% non aveva DOI e il 16% era inesistente, mentre un altro su 115 riferimenti medici ha rivelato che solo il 7% era corretto, con il 47% completamente falso. Per questo motivo Emsley critica il termine “allucinazioni” preferendo un più netto “falsificazione”, poiché l’IA può fabbricare attivamente informazioni ingannevoli.

Ma sarà possibile, un giorno, eliminarle completamente?

Un report di Nature è pessimista a riguardo. La prestigiosa rivista osserva che gli errori nelle citazioni scientifiche si attestino tra il 30% e il 90%. Sebbene l’IA raggiunga un’accuratezza del 98% grazie alla compressione e ricostruzione dei dati, il restante 2% di errore può generare “allucinazioni” pericolose, mitigabili ma non eliminabili completamente, anche con sistemi di verifica, poiché la stessa rete è piena di informazioni errate (dipende, anche in quel caso, che fonti si consultano!).

Perché ChatGPT non riesce a dire la verità (e forse mai ci riuscirà)

Il team che ha sviluppato il nuovo sistema dell’azienda sostiene che un modello più grande può ridurre le allucinazioni dell’IA. “Più informazioni ha a disposizione, meno sarà portato a inventare”, spiega Mia Glaese, responsabile dell’allineamento e dei dati umani in OpenAI. Tuttavia, l’azienda non ha divulgato le dimensioni precise né la potenza di calcolo di GPT-4.5.

Ma perché ChatGPT prende granchi così clamorosi? Non è stato progettato per essere un motore di ricerca avanzato, una fonte di informazioni affidabile? La risposta è complessa (come sintetizzato bene in quest’articolo di TechCrunch), ma fondamentale per capire i limiti di questa tecnologia.

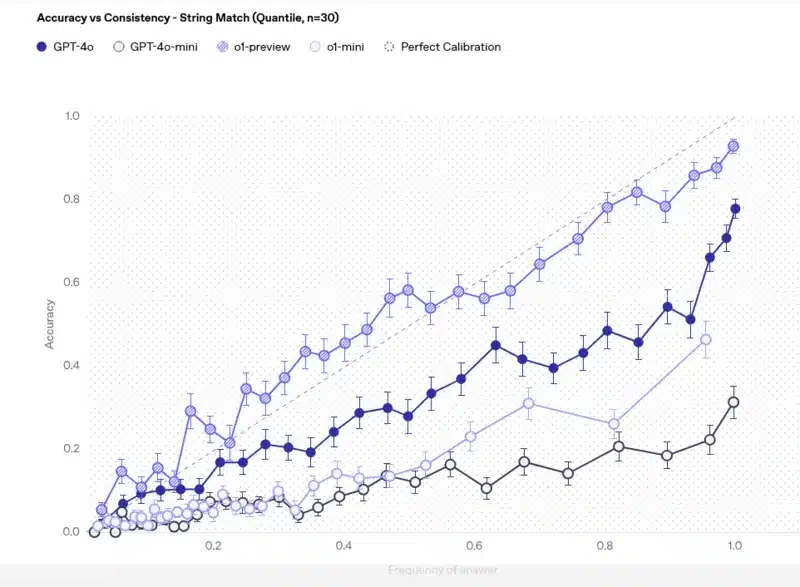

ChatGPT, come tutti i modelli linguistici di grandi dimensioni (LLM), non “capisce” il mondo come lo capiamo noi. Non ha coscienza, non ha capacità di ragionamento nel senso umano del termine. Funziona in modo diverso. È un sofisticato sistema di completamento automatico, addestrato su enormi quantità di testo.

Impara a prevedere la parola successiva in una frase, basandosi su probabilità e statistiche. Quando gli poni una domanda, ChatGPT cerca di “completare” la tua richiesta nel modo più plausibile, basandosi sui dati su cui è stato addestrato.

Ma se i dati di addestramento sono imperfetti, incompleti, contraddittori, o se la domanda è ambigua, il modello può “sbagliare strada” e inventare risposte che sembrano plausibili, ma sono completamente false come spiega.

Matt Kropp, CTO di BCG X, spiega chiaramente: “Le allucinazioni dell’IA derivano da due fattori: dati di addestramento imperfetti e istruzioni insufficientemente precise”. In pratica, ChatGPT non “sa” se una risposta è vera o falsa. Genera la risposta che gli sembra più probabile, punto. E questo è un problema intrinseco alla tecnologia attuale.

Byron Cook di Amazon, esperto di “ragionamento automatico”, è ancora più pessimista: “Non risolveremo mai questo problema al cento per cento“. Le allucinazioni sono, in un certo senso, un limite “fisiologico” dei LLM. Non sono un bug che si può correggere con un aggiornamento software. Sono una conseguenza della natura stessa di questi modelli. Ma qualcosa dalle parti di Amazon, bolle in pentola…

La contromossa di Amazon: la “Ragione Automatica” sarà la soluzione?

Ma non tutto è perduto. Mentre OpenAI sembra quasi rassegnata al problema delle allucinazioni, altri colossi tecnologici stanno cercando soluzioni alternative. Amazon, ad esempio, sta investendo massicciamente in un approccio innovativo: il “ragionamento automatico”.

Di cosa si tratta? In parole semplici, il ragionamento automatico è un campo dell’IA che combina l’intelligenza artificiale con la logica matematica. L’obiettivo è utilizzare la matematica per “dimostrare” la correttezza delle risposte fornite dai modelli linguistici, riducendo così il rischio di allucinazioni.

È un approccio diverso dal machine learning tradizionale, che si basa sull’apprendimento dai dati. Il ragionamento automatico cerca di fornire una “garanzia matematica” di accuratezza. Amazon Web Services (AWS) ha sviluppato uno strumento, Automated Reasoning Checks, basato su questa tecnologia.

L’idea è fornire ai clienti una maggiore certezza sulla veridicità delle informazioni generate dall’IA, soprattutto in contesti critici come la cybersecurity e i settori regolamentati. PwC, ad esempio, utilizza Automated Reasoning Checks per aiutare i clienti del settore farmaceutico a evitare allucinazioni che potrebbero violare le normative sulla pubblicità dei farmaci.

Funzionerà davvero? È ancora presto per dirlo. Rowan Curran di Forrester avverte che il ragionamento automatico non è una “bacchetta magica” e va considerato come parte di un approccio più ampio alla riduzione delle allucinazioni, che include anche tecniche come il Retrieval-Augmented Generation (RAG) e il fine-tuning dei modelli.

Anche Microsoft e Google (ti ricordi di DataGemma?) offrono strumenti per mitigare le allucinazioni, ma nessuno di questi approcci garantisce l’eliminazione totale del problema.

Ma la strada del ragionamento automatico, e in generale la ricerca di soluzioni alternative al machine learning tradizionale, potrebbe rappresentare una speranza per rendere l’IA più affidabile e meno incline a raccontarci frottole.

Non farti ingannare dalla Verità Artificiale

Eccoci giunti al termine di questo approfondimento sulle “cantonate” delle IA. Ci tengo però a dirti che tutto ciò non deve farti diffidare dalle tecnologie, ma usarle con criterio come ti avvertivo già qui!

Anche nel nostro lavoro quotidiano, abbiamo visto come le IA tendano a rassicurarci, a darci ragione e persino a “mentire” per compiacerci. Se chiediamo dati e statistiche su un argomento specifico, e persino se specifichiamo di attenersi a determinate fonti, l’IA potrebbe comunque “forzare” la realtà, inventando dati pur di “confermare” le nostre aspettative o colmare lacune informative.

Quando poi si passa a Deep Research, il livello di scontro si alza drasticamente. Diventa imperativo assicurarsi che le informazioni e le fonti online siano davvero autorevoli e provenienti da fonti certificate; meglio controllare sempre!

Nonostante queste “allucinazioni”, le IA restano strumenti irrinunciabili, capaci di semplificare enormemente il lavoro. Non devono però essere viste come sostituti dell’intelligenza umana, ma come potenti strumenti di supporto. Il controllo umano delle fonti resta fondamentale per evitare errori e danni reputazionali, soprattutto per chi ha un business online.

In ambito SEO, poi, evita improvvisazioni: affidati solo a consulenti esperti. L’obiettivo non è “sfornare” articoli in quantità industriale con l’IA, pensando di vincere una gara a chi produce di più, ma focalizzarsi sulla qualità dei contenuti.

Ricorda: clienti e lettori premiano la qualità, la precisione, l’affidabilità e l’autorevolezza. E anche Google! Per un buon posizionamento, l’uso acritico dell’IA è controproducente.

Le IA sono una realtà, non un’allucinazione collettiva. E chi saprà usarle con intelligenza e responsabilità, controllando sempre le fonti e puntando alla qualità, non potrà che guadagnarci! Contatta la mia agenzia se vuoi saperne di più!

Le allucinazioni di ChatGPT 4.5: Domande & Risposte

Qual è il problema principale di ChatGPT 4.5?

Il problema principale di ChatGPT 4.5 è la persistenza delle allucinazioni, ovvero la generazione di informazioni false. Nonostante i miglioramenti rispetto alle versioni precedenti, OpenAI ammette che il modello produce risposte errate nel 37% dei casi.

Quanto è affidabile ChatGPT 4.5 nel rispondere a domande fattuali?

Secondo il benchmark SimpleQA, ChatGPT 4.5 e GPT-4o forniscono risposte corrette a domande semplici in meno del 40% dei casi. Questo dimostra che anche i modelli più avanzati hanno difficoltà a distinguere informazioni accurate da quelle errate.

Quali sono i rischi di affidarsi completamente a ChatGPT 4.5?

Affidarsi ciecamente a ChatGPT 4.5 per compiti aziendali critici può comportare la diffusione di informazioni errate, danneggiare la reputazione online, compromettere la SEO e generare problemi legali. È essenziale verificare sempre le informazioni fornite dall’IA prima di utilizzarle in contesti professionali.

Non posso credere che il 37% delle risposte sia falso! È un po’ come avere un amico che racconta sempre barzellette sbagliate! 😂

“Che disastro, sembra quasi un quiz a premi! 😅”

Cavolo, il 37% è tantissimo! Io uso sempre ChatGPT, ma controllo sempre le info. Voi come vi comportate? 🤔

“Un po’ come avere un amico che mente… spesso! 😅”

Ma dai, 37% è un sacco! Io di solito controllo sempre, ma a volte mi fido troppo. Voi come fate? 😅

Cavolo, 37% è un rischio enorme! Io di solito verifico sempre, ma a volte mi fido troppo. Voi? 😅