Come Google intende diventare una “AI-first company” e sbaragliare la concorrenza di OpenAI

Il 14 maggio 2024, durante il Google I/O, Google ha presentato una serie di innovazioni significative nel campo dell'intelligenza artificiale. Queste novità includono il "Multi-Step Reasoning", l'organizzazione dinamica dei risultati di ricerca basata su fattori contestuali come il periodo dell'anno, le innovazioni riguardo la ricerca su Google Search.

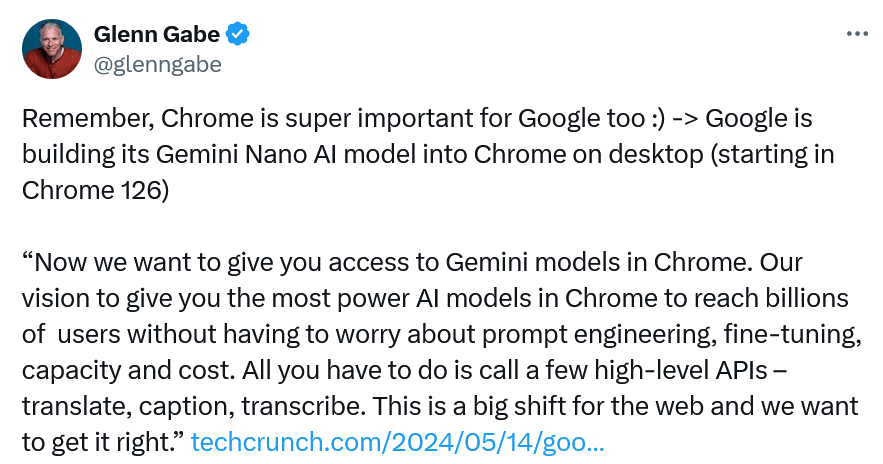

Ma soprattutto il potenziamento di Gemini, l'intelligenza artificiale a cui Google ha dedicato tutte le forze per contrastare l'apparente egemonia di OpenAI, ora con Gemini Nano disponibile anche per telefono. Grazie a Open Astra infatti i modelli text to speech sono migliorati in modo rapido e impensabile fino a poco tempo fa.

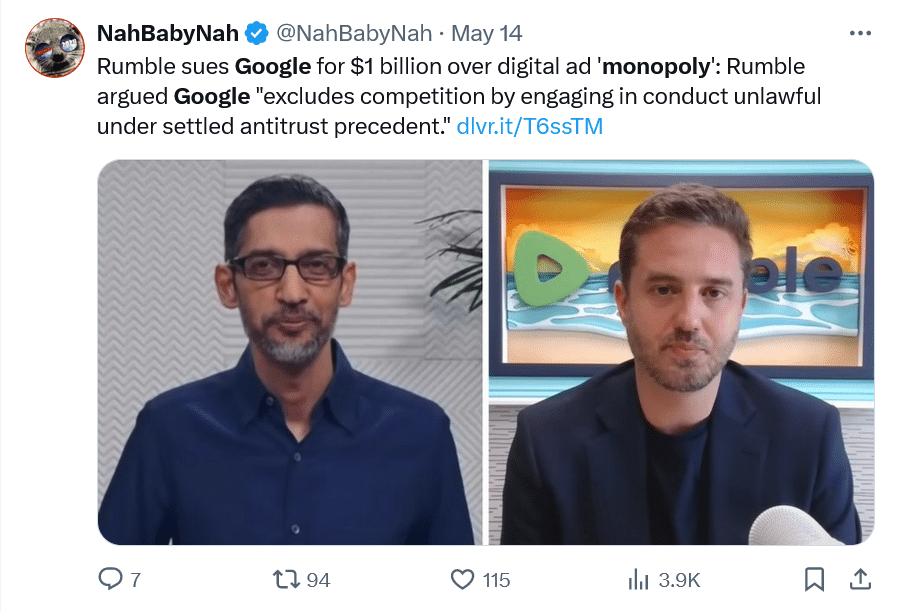

Google ha anche presentato la sesta generazione di Google Cloud TPU, chiamata Trilium, che sarà disponibile entro la fine dell'anno e consentirà all'AI di Google di perfezionare varie funzionalità. Nonostante le innovazioni entusiasmanti, ci sono anche timori riguardo al possibile monopolio di Google e agli impatti etici delle AI.

Tuttavia, l'azienda non ha alcuna intenzione di rallentare i progressi nel campo dell'intelligenza artificiale e all'orizzonte non si intravedono argini istituzionali allo strapotere di Big G.

Il 14 maggio 2024, allo Shoreline Amphitheatre di Mountain View, si è tenuto il Google I/O, la consueta conferenza annuale in cui Big G svela al mondo le sue novità.

L’evento era molto atteso e non ha tradito affatto le aspettative. Milioni di utenti, appassionati e addetti ai lavori hanno seguito la diretta su Youtube e hanno potuto constatare i passi da gigante compiuti dal colosso di Mountain View, specie in tema di intelligenza artificiale.

Google infatti era chiamata a rispondere all’annuncio di Mira Murati, CTO di OpenAI che, pochi giorni prima, aveva anticipato l’uscita di GPT-4o, nuova edizione dell’intelligenza artificiale, più veloce, semplice da usare e soprattutto gratuita.

Già anni fa Sundar Pichai, CEO di Google, aveva dichiarato che la sua società sarebbe presto diventata una “AI first company“, nonostante le critiche e lo scetticismo generale.

Sì, perché da più parti si rimproverava a Big G di essere in netto ritardo sui temi cardine dell’intelligenza artificiale come la tecnologia generativa, l’applicazione di modelli linguistici e l’apprendimento automatico.

Bene, proprio durante l’evento dello Shoreline Amphitheatre, Google ha dato un segnale importante a riguardo e stupito i presenti, presentando al mondo le sue ultime creazioni.

Negli ultimi mesi infatti ha lavorato duramente su Gemini, per contrastare l’apparente egemonia di Open AI, integrando i programmi di chatbot nelle sue App più importanti e sui telefoni Android.

Pichai ha dichiarato ai giornalisti che a Mountain View si lavora a un modello multimodale, che riguardi testo, immagini, video e codici; un modello in grado di trasformare ogni input in output, grazie ai risultati impensabili raggiunti su traduzioni e codifiche, con tempi di latenza ridotti al minimo.

Il CEO ha ricordato agli spettatori come oltre 1,5 milioni di sviluppatori ormai utilizzi Gemini (disponibile in 35 lingue) grazie a un milione di tester, che in appena tre mesi, ha contribuito a potenziare Gemini Advanced.

Insomma, Pichai ha gettato il guanto di sfida a Open AI, ed è apparso sicuro di sé, scatenando l’entusiasmo degli spettatori presenti e di molti a casa, snocciolando dati e successi di Big G.

E già questa settimana Google lancerà AI Overview negli USA che si prevede avrà oltre un miliardo di utenti prima del 2025.

“Con AI Overviews, Google farà il lavoro per voi,” ha affermato Pichai.

“Invece di mettere insieme tutte le informazioni da soli, potete porre la vostra domanda e ottenere una risposta istantanea, completa di una gamma di prospettive e link”.

Sundar Pichai

La ricerca insomma sembra stia procedendo più che bene, Pichai ha rivelato che l’AI ha risposto a miliardi di query, anche le più lunghe e complesse.

Insomma, l’obiettivo di Google è chiaro: rivoluzionare il modo in cui si trovano informazioni e soppiantare la concorrenza.

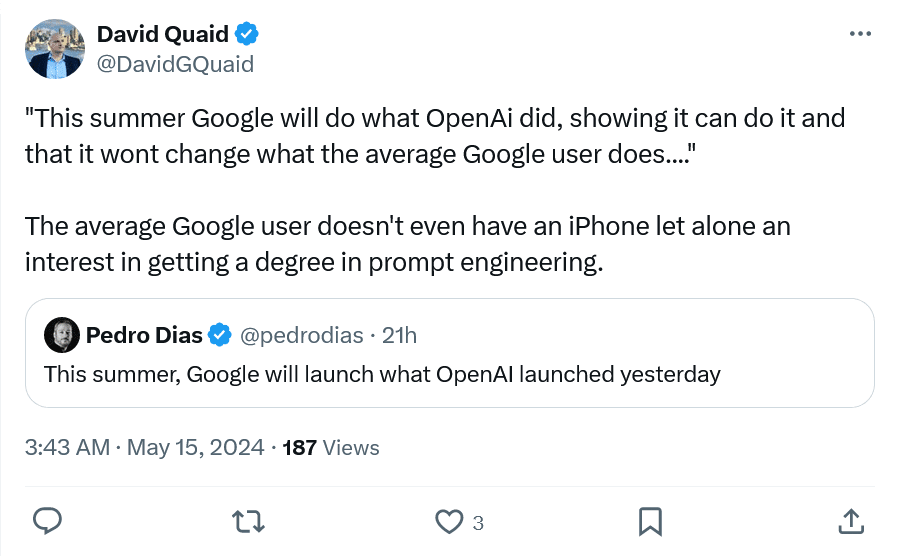

Ma le reazioni polemiche non mancano:

Ma quali sono le novità emerse dal Google I/O 2024? Vediamone alcune

Una delle innovazioni più significative è il “Multi-Step Reasoning“, che permetterà a Google di affrontare domande complesse scomponendole in problemi più piccoli e risolvendoli in sequenza.

Liz Reid, Head of Search, ha dimostrato come questa tecnologia possa essere applicata a varie esigenze quotidiane, come la pianificazione dei pasti.

“Google può ora eseguire la ricerca per voi,” ha spiegato Reid.

“Google non solo troverà le ricette che fanno al caso vostro, ma potrà anche personalizzarle secondo le vostre preferenze alimentari, offrendo un’ampia gamma di opzioni direttamente nei risultati di ricerca”.

Liz Reid

Un’altra innovazione rivoluzionaria è l’organizzazione dinamica delle pagine di ricerca.

Google infatti fornirà agli utenti una pagina di risultati organizzata dall’AI, con cluster di risultati rilevanti basati su fattori contestuali come il periodo dell’anno.

“Ad esempio, cercando il ristorante perfetto a Dallas per celebrare un anniversario, Google potrebbe suggerire ristoranti con musica dal vivo o con fascino storico, basandosi sul contesto e sul periodo dell’anno,” ha dichiarato Liz Reid. “È un’esperienza dinamica che porta l’AI fuori dagli schemi tradizionali e la integra nella pagina intera.”

Liz Reid

Forse la novità più sorprendente è la possibilità di fare domande direttamente ai video tramite Google Search.

In una dimostrazione live, Rose Yao, VP of product , ha mostrato come un video di un problema con un giradischi può essere utilizzato per ottenere risposte immediate da Google. L’AI identifica il modello del giradischi e fornisce soluzioni specifiche, rendendo il processo di risoluzione dei problemi più veloce e accessibile.

Ma non è finita qui, da quest’Estate per esempio Google Foto permetterà di mostrare, con un solo comando, i momenti più importanti relativi a un contatto della rubrica. Con Ask Photo per esempio potremmo, inserendo il numero di targa, trovare la nostra auto tra migliaia di nostre foto.

Insomma, il lavoro di Gemini, le sue infinite possibilità, influiranno su tutti gli strumenti di Google WorkSpace, come Gmail e Meet, per esempio.

Si potrà ottenere un riassunto dei messaggi più rilevanti, individuare le mail più importanti, identificare allegati, ordinarli e classificarli.

Ma soprattutto grazie a Gemini i modelli text to speech saranno in grado di creare conversazioni audio personalizzate e interattive, anche in lingue differenti. Un’altra rilevante novità è che Gemini Nano with Multimodality sarà utilizzabile direttamente dal telefono, con periodi di latenza irrisori. Per esempio, in un video mostrato all’I/O, si può vedere una persona che grazie a Nano scansiona con lo fotocamera del telefono i libri in una mensola e registra i loro titoli in un database.

Un’ulteriore innovazione rivoluzionaria, oltre la fantascienza più estrema, consiste negli agenti dell’intelligenza artificiale di Project Astra.

Pensate a Project Astra come a un Google Lens evoluto, che consentirà di utilizzare la fotocamera dello smartphone per formulare domande su tutto ciò che ci circonda.

Si tratta di sistemi in grado di aiutarci e sostituirci in tutte le operazioni, da quelle più banali di tutti i giorni, a quelle più complesse, come si vede da questo video che mostra l’utilizzo dei Google Glasses, a quanto pare tornati in auge:

Questi agenti sono in grado di pianificare, memorizzare, lavorare con software e app, quasi ‘pensare’, al posto nostro, con la nostra guida e, una volta acquisito le informazioni, anche autonomamente!

Praticamente Black Mirror in confronto sembra più superato di un film muto, in bianco e nero degli anni ’30!

Siamo all’inizio di un cambiamento epocale, che genera vari dilemmi etici e scenari preoccupanti, ma sarà difficile tornare indietro arrivati a questo punto.

Trilium: la nuova TPU di Google

Di cosa necessita Google ora per realizzare quello che ha in mente?

Di macchine per il machine learning dotate di grande potenza di calcolo, ovviamente.

Ed ecco che entra in gioco TPU (Tensor Processor Unit), che addestra le AI come Gemini 1.5 Flash, Imagen 3 e Gemma 2.0, con l’aiuto delle GPU di Nvidia.

Durante l’I/O è stata presentata la sesta generazione di Google Cloud TPU: Trilium!

Trilium sarà disponibile entro la fine dell’anno per i clienti di Google Cloud e consentirà all’AI di Google di perfezionare la ricerca vocale in tempo reale, il riconoscimento immediato di foto, la traduzione linguistica interattiva ai modelli LLM come Gemini, tutti servizi impossibili senza le TPU.

Mentre Google continua a integrare l’AI in tutti i suoi prodotti, è chiaro che l’azienda stia puntando a rendere la tecnologia più accessibile e utile per tutti.

“L’obiettivo di Google è rendere la ricerca più efficiente e intuitiva,” ha affermato Reid.

“Le funzionalità AI integrate miglioreranno continuamente, facilitando la vita quotidiana degli utenti e migliorando la loro esperienza complessiva con Google Search“.

Con queste innovazioni, Google dimostra ancora una volta di essere all’avanguardia nella tecnologia di ricerca, ponendo le basi per un futuro in cui l’AI svolge un ruolo sempre più centrale nelle nostre vite quotidiane.

Ma è tutto rosa e fiori?

I timori degli utenti (e anche i nostri)

Sono comprensibili i timori di molti utenti, il monopolio di Google sembra aumentare ancora, e non si vedono argini all’orizzonte.

L’esperienza dell’utente medio cambierà radicalmente, con le AI overviews non occorrerà più cliccare su un sito trovato sul motore di ricerca, ma le domande degli utenti troveranno risposta direttamente in cima, tra i riepiloghi di Google Search! In questo modo siti web e portali saranno ovviamente penalizzati, più di quanto già siano.

Non vogliamo però essere catastrofisti, certamente si tratta di cambiamenti che avranno un impatto rilevante nella vita di tutti i giorni, innovazioni impensabili fino a solo 15 anni fa, perfino nella fantascienza più sperimentale. Ma sta a noi utilizzare questi nuovi strumenti, e non farci usare da loro. Sembra facile, direte voi…

Ma quindi c’è da gioire e festeggiare per l’avvento della Gemini Era come dice trionfalmente Big G?

Penso che ci voglia misura, come in tutte le cose, un giusto equilibrio tra catastrofisti ed entusiasti di professione.

La cosa che so è che i malumori sul famigerato aggiornamento di Marzo sono scomparsi, per cui almeno per questo, a Google va riconosciuta una certa abilità di comunicazione, almeno nel dettare la linea e stabilire cosa sia importante e cosa non lo sia.

Ci sarà tempo per riflettere sugli scenari futuri e i dilemmi etici che queste novità comporteranno.

Ma facciamo presto, perché Big G non sembra abbia voglia, né interesse, di rallentare.

Takeaways

- L’introduzione di questa tecnologia consente a Google di affrontare domande complesse suddividendole in problemi più piccoli e risolvendoli in modo sequenziale. Ciò amplia le capacità di ricerca e di risposta dell’IA, rendendo possibile l’esecuzione di compiti più sofisticati.

- Google adotta un approccio innovativo nell’organizzazione dei risultati di ricerca, basando la loro disposizione su fattori contestuali come il periodo dell’anno. Questo offre agli utenti un’esperienza di ricerca più personalizzata e mirata, con risultati più rilevanti e contestualizzati.

- Una delle novità più sorprendenti è la capacità di fare domande direttamente ai video tramite Google Search. Questa funzionalità consente agli utenti di ottenere risposte immediate e specifiche da video pertinenti, ampliando notevolmente le possibilità di ricerca e di accesso alle informazioni.

- Il progetto Gemini di Google, focalizzato sull’integrazione di modelli avanzati di intelligenza artificiale, avrà un impatto significativo su tutti gli strumenti di Google WorkSpace. Questo porterà miglioramenti nei modelli text to speech, nelle capacità di analisi dei messaggi e nell’introduzione di agenti AI avanzati come Project Astra.

- La sesta generazione di Google Cloud TPU, chiamata Trilium, promette di potenziare ulteriormente le capacità dell’IA di Google. Trilium consentirà all’IA di perfezionare la ricerca vocale in tempo reale, il riconoscimento di immagini e la traduzione linguistica interattiva, contribuendo così a rendere l’IA di Google più accessibile e utile per tutti.

FAQ

Quali sono le principali innovazioni presentate durante il Google I/O 2024?

Durante il Google I/O 2024 sono state presentate diverse innovazioni significative nel campo dell’intelligenza artificiale. Tra queste ci sono il “Multi-Step Reasoning”, l’organizzazione dinamica dei risultati di ricerca basata su fattori contestuali, la capacità di fare domande direttamente ai video tramite Google Search e l’introduzione di nuove funzionalità all’interno di Google WorkSpace. Inoltre, è stata presentata la sesta generazione di Google Cloud TPU, chiamata Trilium.

Quali sono le principali applicazioni del “Multi-Step Reasoning” presentato durante il Google I/O 2024?

Il “Multi-Step Reasoning” consente a Google di affrontare domande complesse scomponendole in problemi più piccoli e risolvendoli sequenzialmente. Questa tecnologia può essere applicata a varie esigenze quotidiane, come la ricerca di ricette personalizzate secondo le preferenze alimentari dell’utente.

Quali sono i timori riguardo alle innovazioni presentate durante il Google I/O 2024?

Nonostante le innovazioni entusiasmanti, ci sono preoccupazioni riguardo al possibile monopolio di Google nel campo dell’intelligenza artificiale e agli impatti etici di queste tecnologie avanzate. Tuttavia, l’azienda continua a dimostrare un impegno costante nell’integrare l’IA per migliorare l’esperienza degli utenti.