Il 4 Giugno 2024 un gruppo di dipendenti di Google e OpenAI ai massimi livelli ha lanciato un allarme sull'intelligenza artificiale, sostenendo che le aziende stanno ignorando i rischi etici e la sicurezza per perseguire profitti, e chiedendo protezioni per chi denuncia questi pericoli.

13 tra i massimi dirigenti e sviluppatori di Google e OpenAI pubblicano una lettera contro l’utilizzo non etico delle IA, accusando le loro società di pensare solo ai profitti

Negli ultimi mesi il dibattito intorno all’intelligenza artificiale è entrato nel vivo.

Ci si divide tra “ottimisti cronici” che si concentrano solo sugli aspetti positivi e tra catastrofisti che prevedono scenari apocalittici.

Sicuramente l’intelligenza artificiale, se usata con consapevolezza, è foriera di grandi opportunità, ma senza controllo può generare dilemmi etici mica da ridere.

E se è vero che può facilitare la vita di ognuno di noi, potrebbe anche causare la perdita di milioni di posti di lavoro. Per questo motivo i timori delle persone comuni sono comprensibili.

Ma cosa succede quando queste paure provengono da insider, ovvero dipendenti di Google e Open AI per citare le società più importanti?

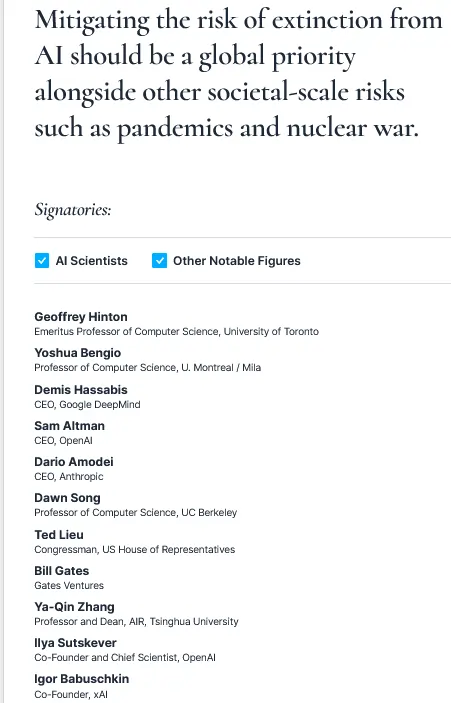

Esattamente un anno fa, l’organizzazione no profit Center for AI Safety pubblicò una lettera apocalittica intitolata “Statement on AI Risk” firmata da scienziati e imprenditori, tra cui Bill Gates, in cui si paventavano i rischi un’intelligenza artificiale fuori controllo, che venivano paragonati addirittura a quelli di una pandemia o di una guerra nucleare.

Tra i firmatari comparivano pezzi grossi di OpenAI come Sam Altman, Ilya Sutskever e Igor Babuschkin ma anche di Google DeepMind come Shane Legg, Ian Goodfellow, Lila Ibrahim e Alexey Dosovitskiy.

Vedere insieme alcune delle migliori menti dei due colossi concorrenti unirsi in un appello che metteva in guardia l’umanità sugli usi delle IA, fece un certo effetto…

Insomma, non si trattava più dei timori dell’uomo della strada o del cittadino comune, ma da addetti ai lavori, e dei più importanti tra loro!

L’IA “potrebbe determinare l’estinzione degli esseri umani” (almeno secondo alcuni pezzi grossi di Google)

Bene, siete pronti a un potente déjà vu?

Esattamente un anno dopo l’appello del Center for AI Safety, il 4 Giugno 2024 è stata pubblicata una nuova lettera sullo stesso tema, ma con toni ancora più preoccupati!

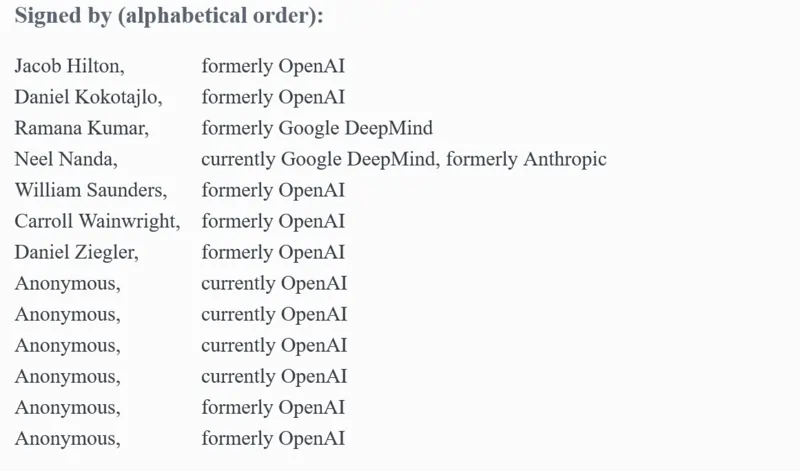

L’appello, intitolato “A Right to Warn about Advanced Artificial Intelligence” è firmato da 13 attuali ed ex dipendenti di Google DeepMind, OpenAI e Anthropic ed è ancora più allarmistico del precedente.

Tra le firme troviamo Jacob Hilton e Daniel Kokotajlo di OpenAI e Ramana Kumar e Neel Nanda di Google DeepMind, nomi di spicco dei due giganti (più qualcuno che preferisce rimanere anonimo per possibili ritorsioni).

In esso si legge:

“Siamo dipendenti ed ex dipendenti di aziende all’avanguardia nell’intelligenza artificiale e crediamo che questa tecnologia possa fornire benefici senza precedenti all’umanità, ma siamo anche consapevoli dei rischi legati all’IA, che vanno dal rafforzamento delle disuguaglianze esistenti, alla manipolazione e alla disinformazione, fino alla perdita del controllo sui sistemi di intelligenza artificiale autonomi che potrebbe determinare l’estinzione degli esseri umani“.

Insomma, la toccano pianissimo.

Nel prosieguo i dirigenti e sviluppatori sottolineano come le loro aziende diano priorità ai profitti e alla crescita economica piuttosto che affrontare le implicazioni etiche e i rischi legati allo sviluppo dell’IA.

Inoltre, sempre secondo loro, gli appelli della comunità scientifica e gli sforzi della politica per regolamentare le intelligenze artificiali non avranno successo se le aziende non collaboreranno.

E non sembra abbiano nessuna voglia (né interesse) a farlo, aggiungo io.

La lettera infine si conclude chiedendo una maggiore protezione per i dipendenti che intendono denunciare questi rischi che le società non intendono divulgare per mero interesse economico.

Infatti i dipendenti di Google e OpenAI temono rappresaglie e licenziamenti per aver espresso opinioni non conformi a quelle delle loro aziende.

Questa lettera però non manifesta solo timori per lo sviluppo di queste tecnologie, ma viene da lontano…

Google accusa i suoi dipendenti (che rispondono per le rime…)

Avete presente il recente Google Leak? La fuga di notizie e documenti riservati rivelati alla stampa che ha evidenziato alcune falle nella sicurezza interna di Big G…

Bene, il 3 Giugno la testata statunitense 404 Media ha pubblicato un articolo riguardante i problemi di sicurezza di YouTube ma anche Maps, Search, Cloud e Adsense, prendendo in considerazione tutti “gli incidenti” avvenuti tra il 2013 e il 2018.

A quanto emerge dall’inchiesta questi problemi (fughe di notizie, in primis) sono stati causati dai dipendenti di Mountain View, non da hacker di misteriose potenze straniere!

Tra gli incidenti citati nell’articolo ce n’è uno riguardante un bug di Street View che nel 2016 ha generato un database di targhe di auto, moto, camion e altri mezzi; un bug di un servizio di trascrizione che ha registrato erroneamente 100 ore di conversazione di bambini e dipendenti che hanno modificato i dati degli utenti in modo che il sistema di tracking gli suggerisca dei prodotti in base a elementi cancellati dalla cronologia di navigazione.

Per non parlare poi di episodi in cui i dipendenti hanno rivelato in anteprima il trailer di GTA VI o hanno usufruito del loro accesso anticipato ai video caricati su YouTube per riscattare buoni Amazon da 10.000 dollari che uno youtuber voleva dare ai suoi iscritti o per rendersi autori di diversi leak videoludici.

È confermato infatti che l’annuncio di Yoshi’s Crafted World nel 2017 sia stato leakkato proprio da un dipendente dell’azienda.

Bene, per questi motivi, Google ha deciso di correre ai ripari e, secondo il motto “colpirne uno per educarne cento“, sta prendendo provvedimenti contro le gole profonde (i cosiddetti whistleblowers) che parlano con la stampa e rivelano notizie riservate o che sfruttano l’azienda per meri interessi privati.

Tra questi ci sarebbero lavoratori scontenti che hanno voluto danneggiare l’azienda per guadagnarci su ma anche chi ha sbagliato per semplice imperizia.

Il problema alla base di questi incidenti è che il colosso di Mountain View conta un elevato numero di dipendenti sparsi per il mondo, e non tutti sono così onesti come si possa pensare (ma per la legge dei grandi numeri, è perfino comprensibile!).

Google ha sempre sostenuto di aver risolto i problemi che gli erano stati segnalati in maniera veloce, ma molti dipendenti si sentono accusati dall’azienda di essere informatori o di avere comportamenti scorretti.

Ecco spiegato perché nella lettera, si chiede maggiore protezione per i whistleblower, oltre che trasparenza e correttezza nelle dinamiche lavorative, più in generale.

Insomma, è chiaro come il rapporto tra il colosso di Mountain View e i suoi dipendenti sia sempre più incrinato, ai minimi storici, oserei dire!

Perciò anche in questo contesto di sfiducia va inquadrato l’appello che mette in guardia sull’utilizzo delle IA.

Come hanno reagito Google e OpenAI?

Qual è stata allora la reazione delle aziende a questa “rivolta”?

Di fronte alla lettera dei dipendenti, entrambe le società hanno risposto con dichiarazioni che sottolineano il loro impegno per la sicurezza e la trasparenza (e ci mancherebbe altro!).

Un portavoce di OpenAI, a questo proposito, in un’appassionata arringa difensiva, ha detto che l’azienda non ha mai rilasciato prodotti prima delle necessarie misure di sicurezza.

Google e Anthropic invece non hanno voluto rispondere almeno per ora alle richieste di commento (ma non poniamo limiti alla Provvidenza!).

In attesa di novità, penso faccia fede questo post di Big G sulla sicurezza e responsabilità (spero che questa policy sia ancora valida!)

Altro fatto interessante da non trascurare: la lettera è stata pubblicata dopo lo scioglimento del team di sicurezza “Superalignment“, che avrebbe dovuto vigilare sui sistemi di intelligenza generale avanzata, la famigerata AGI, definita da Elon Musk un rischio per l’umanità come la bomba nucleare (così, per restare ottimisti!).

In seguito a questo, due dirigenti di OpenAI che guidavano il team, il co-fondatore Ilya Sutskever e Jan Leike, lasciarono l’azienda e ciò generò un effetto domino di dimissioni anche in Google, e a livelli molto alti.

Ma di questo vi ho già parlato nell’articolo sull’epidemia della “dimissionite“…

E ora, che succederà? I dipendenti di Google hanno delle ragioni?

Sicuramente i firmatari della lettera hanno le loro ragioni, d’altronde chi conosce meglio di loro le IA?

Sono i loro creatori, dopotutto!

Mi sembra ovvio che Google faccia i suoi interessi e in questo scenario di competizione con OpenAI l’unica cosa che conta è arrivare primi.

Insomma, c’è poco spazio per problemi etici e dubbi esistenziali che rischiano di rallentare la corsa.

Temo che Big G approfitti di questa lettera per tagliare i rami secchi e così abbia un motivo in più per far fuori i dirigenti “infedeli”, così come fara OpenAI, d’altronde.

Alla fine della fiera questi due colossi sono più simili di quanto si pensi e non agiscono poi così diversamente.

Ma non c’è dubbio che le preoccupazioni espresse dai dipendenti di Google e OpenAI siano fondate.

L’industria dell’IA sta evolvendo a una velocità impressionante, e le implicazioni etiche e sociali di questa tecnologia sono profonde. La mancanza di regolamentazione adeguata e la corsa al profitto senza un’adeguata considerazione dei rischi possono portare a conseguenze disastrose.

Tuttavia, è improbabile che Google o altre aziende tecnologiche ascoltino attentamente questi avvertimenti. Il progresso tecnologico avanza a un ritmo che non aspetta nessuno, e le aziende sono incentivate a spingere sempre più avanti i confini per mantenere la loro posizione di leader nel mercato.

Io, dal canto mio, prometto che vi terrò aggiornati…

Takeaways

- Entrambe le aziende hanno risposto alla lettera dei dipendenti sottolineando il loro impegno per la sicurezza e la trasparenza. OpenAI, in particolare, ha evidenziato la sua esperienza nel non rilasciare prodotti AI senza le necessarie misure di sicurezza.

- Google e Anthropic non hanno fornito commenti immediati alle richieste di spiegazioni. Questa mancanza di risposta può essere interpretata come un segno di difficoltà interna nel gestire le critiche dei dipendenti.

- La pubblicazione della lettera è avvenuta dopo lo scioglimento del team di sicurezza “Superalignment” di OpenAI, che doveva vigilare sui sistemi di intelligenza generale avanzata (AGI). Questo scioglimento ha portato a dimissioni significative, indicando una possibile crisi interna sulla gestione della sicurezza dell’IA.

- Dopo lo scioglimento del team di sicurezza, diversi dirigenti di OpenAI e Google hanno lasciato le rispettive aziende. Questo indica un malcontento diffuso tra i livelli alti delle organizzazioni, preoccupati per la direzione che la gestione dell’IA sta prendendo.

- È evidente che, nonostante le preoccupazioni etiche sollevate, Google e OpenAI sono principalmente focalizzate sulla competizione per il primato nel mercato dell’IA. La rapidità dello sviluppo tecnologico e la spinta verso il profitto sembrano avere la priorità sulle considerazioni etiche e sui rischi sociali, portando a una corsa senza freni per l’innovazione.

FAQ

Come hanno reagito Google e OpenAI alla lettera dei dipendenti?

Di fronte alla lettera dei dipendenti, entrambe le società hanno risposto con dichiarazioni che sottolineano il loro impegno per la sicurezza e la trasparenza. Un portavoce di OpenAI ha detto che l’azienda ha una comprovata esperienza di non rilasciare prodotti AI finché non siano in atto le necessarie misure di sicurezza. Google e Anthropic invece non hanno voluto rispondere almeno per ora alle richieste di commento.

Quali eventi hanno seguito la pubblicazione della lettera?

La lettera è stata pubblicata dopo lo scioglimento del team di sicurezza Superalignment di OpenAI, che doveva vigilare sui sistemi di intelligenza generale avanzata (AGI). In seguito a questo, due dirigenti di OpenAI, Ilya Sutskever e Jan Leike, hanno lasciato l’azienda, generando un effetto domino di dimissioni anche in Google.

I dipendenti di Google hanno delle ragioni per le loro preoccupazioni?

Le preoccupazioni espresse dai dipendenti di Google e OpenAI sono fondate. L’industria dell’AI sta evolvendo a una velocità impressionante, e le implicazioni etiche e sociali di questa tecnologia sono profonde. La mancanza di regolamentazione adeguata e la corsa al profitto senza un’adeguata considerazione dei rischi possono portare a conseguenze disastrose. Tuttavia, è improbabile che Google o altre aziende tecnologiche ascoltino attentamente questi avvertimenti.