Google sta potenziando strumenti come SynthID e Content Credentials 2.1 per segnalare immagini e video creati con IA, migliorando la trasparenza e la tracciabilità dei contenuti digitali. In questo modo sarà possibile identificare foto e video realizzati con le IA, per contrastare fake-news e disinformazione.

Gli strumenti SynthID e Content Credentials 2.1 saranno perfezionati per garantire più trasparenza e contrastare le fake-news, ma quali sono i rischi?

Ti è mai capitato di chiederti se quella foto apparentemente perfetta fosse reale o creata con l’intelligenza artificiale?

Se la risposta è sì, beh, non sei il solo. Oggi, come sai, i contenuti realizzati con Ie IA sono davvero irriconoscibili; ah, bei tempi quelli in cui si poteva capire da ombre e riflessi innaturali o da mano con sei dita!

Il dubbio sull’autenticità di ciò che vediamo quotidianamente è perfettamente comprensibile, ma alimenta complottismi e sfiducia negli utenti.

Ciò che vediamo sui nostri dispositivi infatti influenza il modo in cui votiamo alle elezioni, i prodotti che decidiamo di acquistare, le decisioni che prendiamo ogni giorno in azienda, per cui il tema della trasparenza non è cosa da poco. Non si tratta solo di capire se la foto di quel tramonto è reale oppure no: c’è molto di più in gioco.

Proprio per questo motivo Big G sta perfezionando (e presto renderà disponibili) alcune nuove funzionalità che segnaleranno le immagini o i video creati con le IA, per mettere un po’ di ordine in questa selva di contenuti di dubbia provenienza.

Come annunciato sul suo blog, i nuovi strumenti saranno integrati su Google Lens e Youtube e consentiranno di distinguere tra immagini e video creati da una fotocamera, modificati con un software o addirittura generati interamente dall’intelligenza artificiale.

I propositi sembrano buoni, peccato che la strada non sia affatto semplice…

L’impegno di Google per la provenienza e l’autenticità dei contenuti (decisione di facciata, o reale?)

A Mountain View sanno che i temi della trasparenza e della veridicità delle fonti sono sempre più rilevanti e la diffusione di fake-news rappresenta un problema reale che non conviene a nessuno, né agli utenti (che diventano sempre più scettici), né ai creatori di contenuti (che si trovano a competere con concorrenti sleali in un gioco al ribasso), e men che meno a Google (che perde fiducia, oltre che denaro per far ordine ed eliminare contenuti spazzatura).

Per queste ragioni, Google aderisce da febbraio 2024 alla C2PA (Coalition for Content Provenance and Authenticity), una coalizione che si occupa di creare standard tecnici per la tracciabilità delle immagini e dei video online.

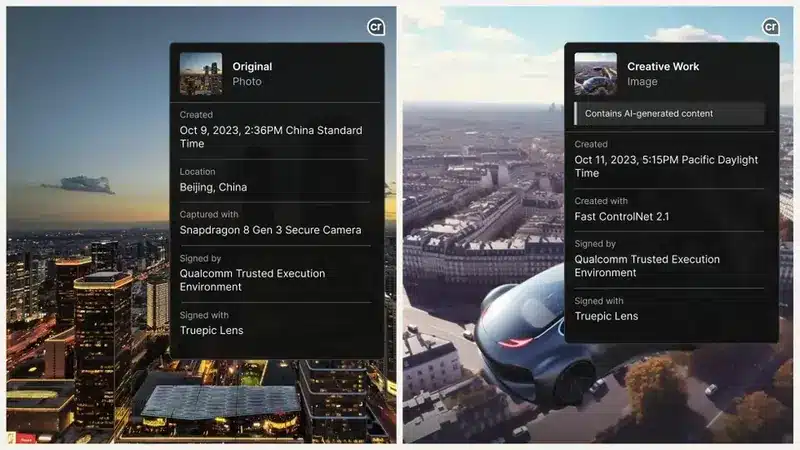

La C2PA ha sviluppato uno standard, attualmente alla versione 2.1, che consente di tracciare la provenienza dei contenuti digitali, permettendo di capire con quali strumenti sono stati creati o modificati.

Il sistema che Google sta utilizzando per le sue nuove funzionalità è basato proprio sugli standard della C2PA, una delle più grandi iniziative globali per affrontare la questione delle immagini generate dall’IA.

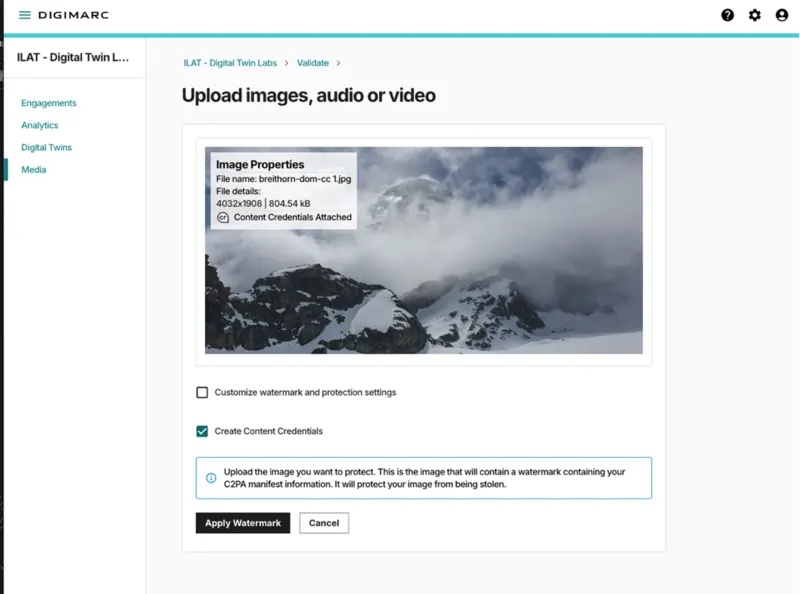

Lo scopo è creare una “traccia digitale” che segua il contenuto dall’origine, fornendo informazioni come il tipo di fotocamera utilizzata o il software che ha generato il file.

La C2PA è sostenuta da giganti del settore come Amazon, Microsoft, Adobe, Arm, OpenAI, Intel, Truepic e, naturalmente, Google. Ciò ti fa capire quanto il discorso non sia solo etico, ma frutto di un calcolo economico. Sì, perché un pubblico (e un consumatore) sfiduciato e sospettoso non conviene a nessuno!

C2PA: un’iniziativa ambiziosa, non priva di ostacoli

Nonostante l’importanza di questa iniziativa, l’adozione dello standard C2PA è ancora lenta.

Anche se rappresenta una pietra miliare per la trasparenza digitale, solo pochi strumenti hardware e software lo supportano pienamente.

Attualmente, solo alcune fotocamere di Leica e Sony includono i metadati C2PA, mentre grandi nomi come Nikon e Canon hanno promesso di adottare lo standard, ma non hanno ancora implementato pienamente il supporto. Il vero test sarà vedere se e come giganti come Apple e la stessa Google integreranno il supporto C2PA nei dispositivi mobili come iPhone e Android in maniera efficace.

Google, da parte sua, ha giocato un ruolo di primo piano nello sviluppo dell’ultima versione dello standard tecnico, la versione 2.1. Questa include una nuova funzione, chiamata C2PA trust list, che permette a piattaforme come Google Search di confermare la provenienza del contenuto.

Come spiega Laurie Richardson, Vice President, Trust & Safety di Google: “Ad esempio, se i dati mostrano che un’immagine è stata scattata con un determinato modello di fotocamera, la trust list aiuta a validare che questa informazione sia accurata.”

Proprio per questo Big G sta acquisendo varie società, anche piccole ma innovative, che si occupano di ricerca sulle intelligenze artificiali come Character AI e ha corteggiato a lungo Wiz, società di cybersecurity, anche se senza successo.

Content Credentials 2.1: la chiave per una maggiore trasparenza (ma basterà?)

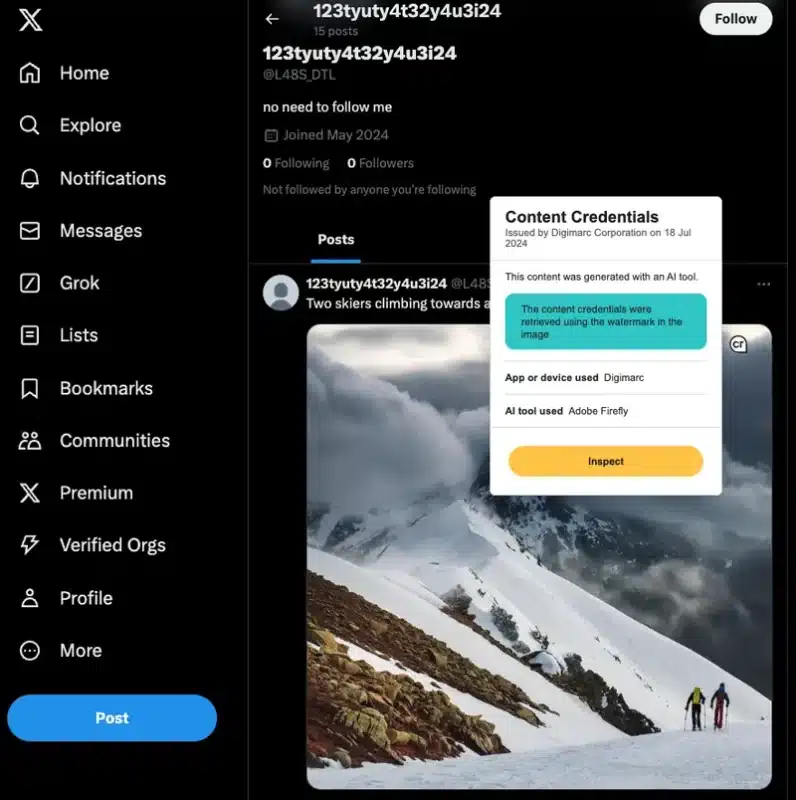

Una delle tecnologie chiave che Google sta integrando è Content Credentials 2.1, un sistema di autenticazione che fornisce informazioni dettagliate sulla provenienza di un’immagine. Questo nuovo strumento sarà in grado di indicare se un’immagine è stata scattata con una fotocamera, modificata con software come Photoshop o addirittura generata da un modello di IA.

Devi sapere che presto sarà implementato all’interno di prodotti come la Ricerca Google, Google Lens e Youtube, per cui meglio cominciare a familiarizzarci.

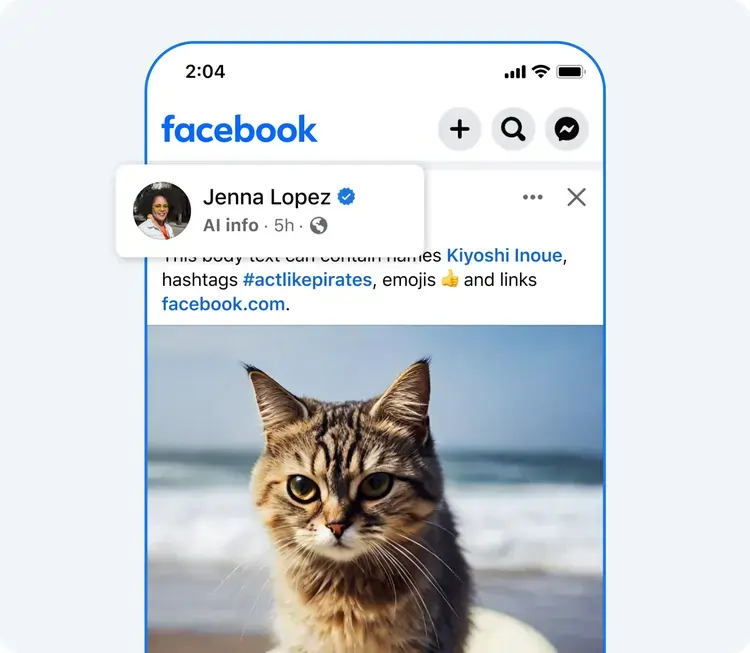

La sua funzione “informazioni su questa immagine” permetterà agli utenti di ottenere informazioni sull’origine dei file, fornendo dettagli utili per capire se un’immagine è stata generata da una macchina o da un essere umano. Questo è particolarmente rilevante in un contesto in cui i contenuti visivi generati dall’IA stanno diventando sempre più sofisticati e difficili da distinguere da quelli reali.

Laurie Richardson, importante dirigente di Big G, ha scritto sul blog di Google:

“Stabilire e segnalare la provenienza dei contenuti rimane una sfida complessa, con una serie di considerazioni basate sul prodotto o sul servizio. Pur sapendo che non esiste una soluzione definitiva per tutti i contenuti online, la collaborazione con altri operatori del settore è fondamentale per creare soluzioni sostenibili e interoperabili. Ecco perché stiamo anche incoraggiando un maggior numero di fornitori di servizi e hardware a prendere in considerazione l’adozione delle Content Credentials di C2PA“.

SynthID: la filigrana digitale per IA

Oltre a Content Credentials 2.1, Google Deep Mind ha sviluppato SynthID, una sorta di “filigrana” digitale per i contenuti generati dall’intelligenza artificiale.

SynthID, introdotto per la prima volta ad agosto 2023, è stato pensato per applicare un watermark digitale invisibile a immagini e video creati dall’IA, offrendo così un modo per identificare l’origine di questi contenuti, come puoi verificare tu stesso sul blog di Google Deep Mind.

Di recente, Google ha espanso le capacità di SynthID per includere anche la filigranatura di testi e video generati dall’intelligenza artificiale.

Questa mossa arriva in risposta alle crescenti preoccupazioni etiche e sui rischi legati alla disinformazione (già l‘aggiornamento di Google di agosto contro i deep-fake andava in questa direzione) e agli attacchi di phishing.

Ora, il sistema SynthID sarà in grado di filigranare anche i testi generati attraverso l’app Gemini e i video creati con Veo, il sofisticato modello generativo video di Google.

Per quanto riguarda i testi, Google ha sviluppato un metodo per inserire filigrane digitali senza impattare sulla qualità del contenuto. Il sistema funziona regolando sottilmente i punteggi di probabilità dei token, ossia i “mattoni” che compongono i testi generati dall’IA. Queste regolazioni creano un pattern unico che consente di identificare il contenuto generato, anche se viene leggermente parafrasato o modificato.

Tale tecnologia risulta particolarmente efficace per testi lunghi e complessi, come saggi o sceneggiature, mentre potrebbe avere una precisione inferiore con risposte brevi e di natura fattuale.

È importante notare che SynthID non è una soluzione perfetta e può incontrare difficoltà nel riconoscere testi che sono stati riscritti pesantemente o tradotti, ma rappresenta comunque un passo avanti per l’identificazione dei contenuti generati dall’IA e può essere combinata con altri metodi di rilevamento per migliorarne l’affidabilità.

Per i video, invece, il processo prevede l’inserimento di un marcatore digitale nei pixel di ogni frame video. Questa tecnica, ispirata allo strumento di filigranatura per immagini di Google, garantisce che, anche con l’evoluzione delle tecnologie di generazione video, l’origine dei video creati dall’IA possa essere identificata.

Infine, te lo riporto perché ha stupito anche me, Google ha dichiarato che intende rendere open-source la filigranatura dei testi attraverso SynthID. Come se a Mountain View volessero smentire chi li accusa di premiare i contenuti spam creati con le IA.

Mi pare una notizia positiva, ti aggiornerò sulla questione…

Fin qui “buone notizie”, o almeno buoni propositi da parte di Big G, ma vediamo qualche criticità.

I problemi dell’adozione C2PA: eccoci ai tasti dolenti

Una delle maggiori criticità è la lentezza nell’adozione da parte di molti produttori di hardware e software.

Attualmente, infatti, solo una manciata di fotocamere e strumenti di editing supportano il sistema.

Adobe Photoshop e Lightroom, per esempio, sono tra i pochi software di editing che possono aggiungere dati C2PA, ma strumenti popolari come Affinity Photo e Gimp ancora non lo fanno.

Facebook e Instagram sono due delle piattaforme più grandi che verificano i contenuti per marcatori come lo standard C2PA, ma segnalano solo le immagini che sono state manipolate utilizzando strumenti di IA generativa — nessuna informazione viene presentata per convalidare le immagini “reali.”

Invece, LinkedIn (per ora) non consente agli utenti di scaricare i file originali con i metadati, impedendo la verifica indipendente dell’autenticità dei contenuti.

La speranza di alcuni è che Big G, grazie all’integrazione nei risultati di ricerca, potrebbe spingere altri giganti del settore a seguire questa strada, rendendo più comune l’uso delle etichette che indicano la provenienza dei contenuti.

A Mountain View stanno cercando di affrontare queste difficoltà integrando i metadati C2PA non solo nei suoi prodotti principali come Lens e Ricerca, ma anche nei sistemi pubblicitari, con l’obiettivo di utilizzare questi segnali per applicare politiche chiave riguardanti la trasparenza e la fiducia nei contenuti.

Ti devo confessare anche un mio cattivo pensiero: temo che Google possa, almeno inizialmente, penalizzare siti web che, secondo il suo insindacabile giudizio, utilizzano le IA in modo “improprio”. Non vorrei che si scatenasse una psicosi anti-IA, che possa portare a segnalazioni ingiustificate, tipo gli oscuramenti ingiusti per reputation abuse, di cui ti ho parlato in passato. Insomma, occorre stare in guardia.

Inoltre vorrei brevemente segnalarti altri 3 possibili punti deboli del C2PA, un po’ più pessimisti:

- Il C2PA si basa sul principio di “fiducia” piuttosto che su un approccio “zero trust”. Gli utenti devono fidarsi che chi firma i metadati e il certificato abbia agito in buona fede, senza un reale meccanismo di verifica efficace a monte;

- I metadati possono essere falsificati con facilità. Anche se C2PA applica una firma crittografica, questa non garantisce l’autenticità del contenuto, ma solo che non è stato modificato dopo la firma;

- C2PA ha difetti architetturali profondi, come l’incapacità di validare le informazioni di autenticazione in modo sicuro e l’assenza di un efficace sistema di revoca dei certificati. Questi difetti richiederebbero una riscrittura del sistema, non semplicemente patch o correzioni minori.

Google vuole ristabilire la fiducia degli utenti, ma basterà contrastare le fake-news create con le IA?

Eccoci arrivati al termine di questo articolo. Spero di non averti intimorito, ma come hai visto il tema del riconoscimento di contenuti creati con le IA è sempre più rilevante, specie in periodo di elezioni USA (anche in questo senso vanno viste le recenti innovazioni di Google in merito alle IA).

Con l’ascesa dell’intelligenza artificiale generativa (GenAI), e il conseguente aumento del rischio di manipolazione dei media, i consumatori di contenuti si chiedono cosa possa o non possa essere affidabile online. Perciò, ristabilire la fiducia nei contenuti digitali (ti ricordo che la fiducia degli esperti SEO in Google è ai minimi storici) è un argomento non più evitabile per Big G (e per nessun altro).

L’idea che in futuro ogni immagine o video possa essere tracciabile, dal momento della sua creazione fino alla pubblicazione online, potrebbe aiutare a combattere fenomeni sempre più diffusi come la disinformazione e le truffe digitali.

Questa campagna di Google contro le IA utilizzate in modo fraudolento si inserisce nel quadro di contrasto alle IA utilizzate per spam e click baiting, proprio per smentire chi invece accusa Big G di premiare i contenuti spam realizzati con IA.

Ma, come ti sarai già accorto, non c’è garanzia che tutti si conformeranno a questi nuovi standard. Ad oggi, lo standard C2PA è supportato da colossi come Amazon, Microsoft, Adobe, e OpenAI, ma la strada per una vera diffusione è ancora lunga.

Realizzare contenuti con le IA è una grande risorsa che può far risparmiare tempo e aiutare a essere più precisi, anche nella verifica delle fonti, ma il pericolo è che venga utilizzata per manipolare le persone o ingannarle (oppure realizzare contenuti scadenti che inquinano il web).

Per questo motivo, ben vengano i nuovi strumenti di Google, ma che siano davvero efficaci e non solo pezze che rischiano di essere peggiori del buco.

Takeaways

- Google sta introducendo strumenti come SynthID e Content Credentials 2.1 per segnalare in modo più efficace immagini e video creati o modificati con IA. Questo permetterà agli utenti di identificare con maggiore facilità i contenuti generati artificialmente.

- Google potrà fornire una “traccia digitale” che seguirà il contenuto dalla sua origine. Questo aiuterà a capire se una foto o un video sono stati scattati con una fotocamera, modificati o creati interamente dall’IA.

- Nonostante l’ambizione del progetto, l’adozione dello standard C2PA è lenta. Attualmente solo alcuni dispositivi e software supportano questa tecnologia, e Google dovrà affrontare le sfide dell’integrazione su larga scala, soprattutto per quanto riguarda i dispositivi mobili.

- Oltre a identificare immagini e video creati con IA, Google ha espanso SynthID per includere anche i testi. Questo consentirà di marcare contenuti testuali senza comprometterne la qualità, un passo avanti per garantire una maggiore sicurezza e prevenire disinformazione.

- L’obiettivo di Google è ricostruire la fiducia nei contenuti online, contrastando fenomeni come fake news, deep fake e disinformazione. Il successo di questa iniziativa dipenderà dalla sua efficacia nel coinvolgere altri attori del settore e dall’adozione diffusa degli standard proposti.

FAQ

Che cos’è SynthID e come funziona?

SynthID è una tecnologia sviluppata da Google DeepMind che inserisce una filigrana digitale invisibile in immagini e video generati con IA, permettendo di identificare l’origine dei contenuti anche dopo eventuali modifiche.

Qual è l’obiettivo degli strumenti Content Credentials 2.1?

Content Credentials 2.1 mira a fornire informazioni dettagliate sull’origine e la provenienza dei contenuti digitali, aiutando gli utenti a identificare se un’immagine o un video sono stati creati o modificati con IA, e aumentando così la trasparenza online.

Che cos’è la C2PA e perché è importante?

La C2PA (Coalition for Content Provenance and Authenticity) è una coalizione globale che sviluppa standard tecnici per tracciare la provenienza di immagini e video online, garantendo maggiore trasparenza sull’origine dei contenuti digitali.